Démarrer avec un nouveau client en SEO : 5 actions indispensables

Chaque consultant SEO a ses routines et process. Pour ma part, lorsque je débute une prestation SEO avec un nouveau client, il y a cinq actions que je mets systématiquement en place. Je vous les détaille dans cet article.

Sommaire

- 1 Sauvegarder les données Google Search Console (et automatiser la sauvegarde)

- 2 Faire une sauvegarde des mots clés positionnés (et des URL positionnées)

- 3 Mettre en place un monitoring anti-régression SEO

- 4 Mettre en place un monitoring sur les principaux backlinks

- 5 Faire un crawl complet du site du client et sauvegarder les données

- 6 Conclusion

Sauvegarder les données Google Search Console (et automatiser la sauvegarde)

Les données Google Search Console ont un historique limité à 16 mois. Il est donc important :

- De sauvegarder les données historiques

- De mettre en place une sauvegarde mensuelle (a minima) des données

Ces données Google Search Console sont capitales car, quand bien même vous avez un outil de web analyse en complément :

- Les données mesurées ne sont pas les mêmes : Google Search Console comptabilise les clics depuis les résultats de recherche de Google

- Vous n’êtes pas à l’abri que les données de votre outil de web analyse soient faussées : plateforme de gestion du consentement (CMP) qui ne permet de récupérer qu’une partie des données, tracking mal paramétré, etc. J’ai déjà rencontré plusieurs cas où le client m’a sollicité pour comparer les données GSC avec les données de trafic naturel de l’outil d’analytics… pour se rendre compte que le « problème sur le SEO » venait en réalité du tracking

- Les données relatives au trafic naturel proposées par Search Console sont beaucoup plus riches en informations

Vous pouvez facilement sauvegarder vos données Google Search Console en utilisant Google Sheets et l’extension Search Analytics for Sheets.

Pour les utilisateurs plus avancés, et surtout pour les sites à forte volumétrie, vous pouvez plutôt exporter vos données Search Console vers BigQuery, ou privilégier d’autres solutions en passant par l’API.

Sauvegarde des données historiques

Je commence toujours par sauvegarder les données quotidiennes de clics sur les 16 derniers mois. Ainsi, les données historiques de trafic naturel depuis Google sont sauvegardées. D’ici plusieurs mois, quand l’historique se sera étoffé, il sera alors possible d’établir des comparaisons par rapport à l’année précédente.

En plus de cela, je sauvegarde toutes les données liées :

- Aux requêtes de recherche

- Aux URL qui ont généré du trafic

- Aux couples requête de recherche + URL

Selon le client, il peut aussi être intéressant de ne pas se contenter des données « Web », mais d’ajouter une sauvegarde de l’historique des données des autres types de recherche (image, vidéo, Discover, etc.).

Les sauvegardes peuvent être effectuées sur la totalité de la période, ou segmentées par mois.

Mettre en place une sauvegarde automatique

Une fois les données historiques sauvegardées, il s’agit désormais d’automatiser la sauvegarde des futures données. Search Analytics for Sheets permet justement de planifier une sauvegarde quotidienne ou mensuelle.

Faire une sauvegarde des mots clés positionnés (et des URL positionnées)

Deuxième étape : sauvegarder l’ensemble des mots clés et des URL sur lesquels se positionne le client. Bien sûr, vous retrouvez les données associées aux requêtes de recherche et aux URL sur Google Search Console. Mais, en complément, il est intéressant de passer par un outil SEO pour :

- Exporter tous les mots clés sur lesquels se positionne le site du client, avec la position sur le mot clé et l’URL positionnée

- Exporter l’ensemble des URL positionnées du site

Ces données ont peut-être déjà été exportées par ailleurs dans le cadre d’un audit sémantique. Dans tous les cas, elles pourront toujours être utiles par la suite, par exemple pour comparer l’évolution du positionnement depuis le début de la mission avec le client. Elles permettent surtout de faire une photo à un instant T du positionnement du site du client.

Pour ma part, j’utilise Haloscan et SEObserver pour exporter ces données.

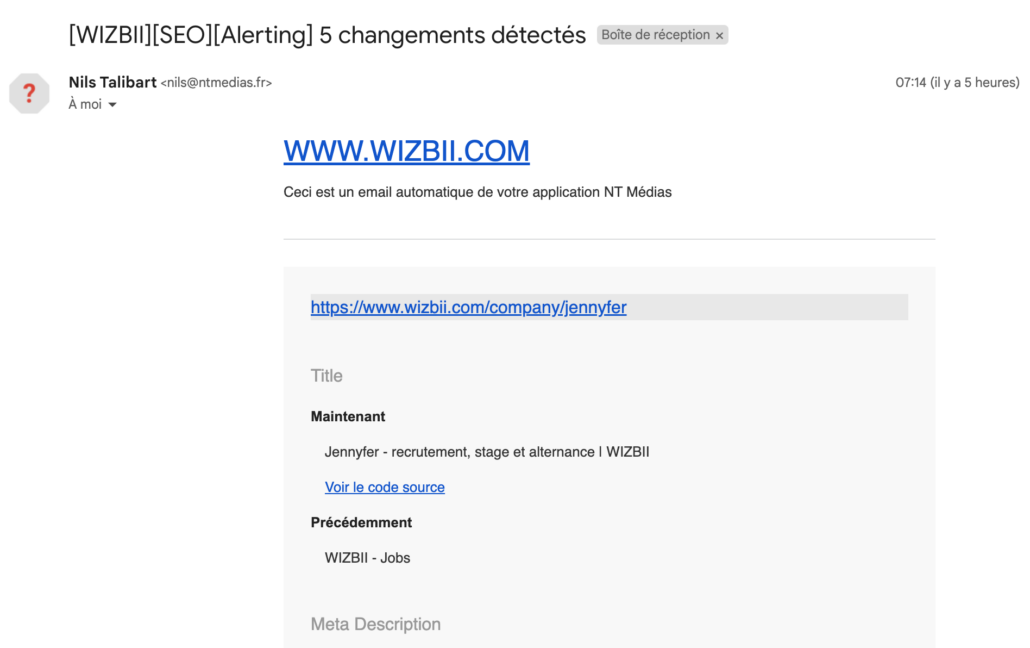

Mettre en place un monitoring anti-régression SEO

Troisième étape, ô combien importante : je mets en place un monitoring sur toutes les pages les plus importantes du site (en m’assurant de couvrir également l’ensemble des templates de page) pour éviter toute régression SEO.

Pour cela, mon outil de prédilection, c’est Oseox, avec sa partie Alerting. Oseox Alerting se charge de faire un crawl toutes les heures sur l’ensemble des URL que j’ai ajoutées en monitoring, et me prévient par e-mail en cas de modification sur tout élément important pour le SEO : title, meta description, balise H1, meta robots, URL canonique, balises hreflang, code réponse de la page, etc.

Il est aussi possible de vérifier la présence sur la page d’une chaîne de caractères ou de détecter toute modification d’un bloc de contenu. Idéal pour s’assurer qu’un bloc de maillage interne ne va pas disparaître, que vos données structurées sont toujours là, ou que votre balise Google Analytics n’a pas sauté.

Je mets en place ce monitoring anti-régression sur :

- Toutes les pages les plus importantes du site :

- Pages qui génèrent le plus de trafic : vous pouvez reprendre la liste des URL positionnées exportées précédemment, en les triant par trafic décroissant, et en prenant toutes vos top URL

- Pages qui génèrent le plus de chiffre d’affaires (URL des top fiches produits sur un site e-commerce par exemple)

- Tous les templates de page, c’est-à-dire que, sur l’ensemble des URL ajoutées, je m’assure que tous les templates de page du site sont bien représentés. Par exemple, sur un site e-commerce, il me faut au moins : des fiches produits, des pages de catégories, des pages de facette, des pages de contenu, etc.

- Quelques anciennes URL redirigées importantes

Ainsi, je suis alerté par e-mail dans l’heure pour la moindre modification ayant un impact SEO sur une de ces URL.

Ce monitoring anti-régression SEO est vital chez certains clients. Des exemples d’alertes reçues ?

- Une directive Disallow ajoutée au fichier robots.txt pour l’ensemble des URL du site chez un gros e-commerçant (plusieurs millions d’euros de chiffre d’affaires annuel)

- Un ancien plan de redirection qui a sauté (des centaines de redirection 301 supprimées)

- Une balise meta robots noindex ajoutée par erreur

- Un bloc de maillage interne vers les pages de liste pour les arrondissements de Paris, Lyon et Marseille qui disparaît sur un site de type annuaire

- Etc.

Je pourrais ainsi multiplier les exemples.

A noter que, outre l’Alerting, Oseox propose parmi ses outils :

- Monitoring : cette fois, le crawl n’a pas lieu toutes les heures, mais tous les jours. Utile pour des URL moins importantes

- Sitemap : crawl quotidien sur toutes les URL de votre sitemap XML pour vérifier qu’elles répondent bien en 200

- HTTP : crawl quotidien sur une liste d’URL pour vérifier leur code réponse. Utile pour s’assurer que vos URL répondent bien en 200… mais aussi que vos redirections 301 sont toujours en place !

Si vous n’avez pas mis en place de monitoring anti-régression SEO, c’est aujourd’hui pour moi un indispensable, et j’en fais bénéficier tous mes clients. Je vous recommande d’ailleurs chaudement Oseox pour cela.

Mettre en place un monitoring sur les principaux backlinks

Outre le monitoring anti-régression SEO, je mets aussi en place un monitoring sur les principaux backlinks obtenus par le site de mon client. La perte d’un gros backlink peut en effet s’avérer très préjudiciable pour la visibilité de son site dans les résultats de recherche de Google.

Par ailleurs, si le client a acheté des liens, il est important de s’assurer :

- Qu’ils ne sont pas supprimés au bout d’un certain temps

- Qu’ils ne passent pas en nofollow

- Que la page depuis laquelle est effectué le lien ne passe pas en noindex ou ne soit pas supprimée

- Que la page depuis laquelle est effectué le lien est toujours indexée par Google

Là encore, Oseox, avec son outil Link, permet de surveiller tout cela. Je récupère donc la liste des principaux backlinks de mon client depuis un outil comme SEObserver ou Babbar, et je les ajoute sur Oseox Link, qui va automatiquement récupérer l’ancre et l’URL de la page cible.

Je reçois ainsi une alerte dès qu’un lien a été modifié ou supprimé, ou que la page qui fait le lien n’est plus indexée.

Evidemment, cette liste de liens initiale est complétée au fur et à mesure du travail d’acquisition de liens effectué avec le client au cours de l’accompagnement SEO.

Faire un crawl complet du site du client et sauvegarder les données

C’est l’action la plus évidente, et que j’effectue de toutes façons dans le cadre d’un accompagnement SEO – qui débute généralement par une phase d’audit : faire un crawl complet du site du client avec Screaming Frog (ou un autre crawler selon la volumétrie de pages, comme OnCrawl ou Botify).

Comme pour l’export des mots clés et URL positionnés, ce crawl initial permet de faire une photo du site au début de la prestation. Il sera alors toujours possible de reprendre ce crawl par la suite, le comparer à de futurs crawls, etc.

Sur Screaming Frog, il faut bien penser à cocher l’option « Stocker le HTML » lors de la configuration du crawl (menu Spider > Extraction), pour ainsi conserver tout le contenu des pages explorées par le crawler.

Et ensuite, on sauvegarde bien son crawl, et on exporte quelques fichiers utiles (liste des URL internes, etc.) au format Excel ou CSV pour exploiter ces données.

Conclusion

Je vous ai décrit mon process de démarrage avec un nouveau client en tant que consultant SEO, donc prestataire externe. Cependant, si vous êtes responsable SEO ou chef de projet SEO en interne, ou même éditeur de sites, ces actions pourront aussi vous être utiles et vous donner quelques idées. Le monitoring SEO, en particulier, est trop souvent négligé, alors qu’il est pour moi désormais indispensable.

Laisser un commentaire

Rejoindre la discussion?N’hésitez pas à contribuer !